Introducción

El inicio de las evaluaciones a los programas sujetos a reglas de operación (PSRO), aun con sus errores y deficiencias, puede considerarse un momento de quiebre en la evolución de las políticas públicas en México e incluso un parteaguas, pues por primera vez en la historia del país se empezó a llevar a cabo un esfuerzo sistemático y obligatorio de evaluación externa de los programas sociales federales. Si bien esto constituye su principal resultado y fortaleza, este proceso ha mostrado tanto avances como retrocesos, así como debilidades y carencias que son el objeto de análisis de este artículo.

En pocos años ha cambiado radicalmente la cultura de la evaluación entre los servidores públicos. A principios de este siglo, ni las unidades responsables de la operación de los programas (UROP) ni las unidades contratantes de las evaluaciones (UCE)1 tomaban en serio las evaluaciones y lo único que les interesaba era tener el acuse de recibo de que se habían entregado a tiempo en la Secretaría de Hacienda y Crédito Público (SHCP) y en la Cámara de Diputados para evitar ser observados, o “represalias” en la asignación del presupuesto en el siguiente ejercicio.

En 2017 estamos aún lejos de la apropiación de los resultados para la mejora sistemática de los programas, pero -en el extremo opuesto- también lejos del presupuesto estrictamente administrativo que imperaba antes de 1976. Sin embargo, los documentos de la SHCP y del Consejo Nacional de Evaluación de la Política de Desarrollo Social (Coneval) tienden a presentar el proceso sólo desde la perspectiva de los logros (e incluso como acabado), mientras los evaluadores con frecuencia lidiamos con muchos obstáculos que dichas autoridades parecieran desconocer o prefieren ignorar. Lo que se pretende en este artículo es darles voz a estos actores, sin dejar de reconocer los logros del proceso.

En el primer apartado se comentan brevemente los momentos relevantes de la evaluación a los programas gubernamentales y las políticas públicas federales en México; en los apartados siguientes se analizan los que -desde la perspectiva de los evaluadores- constituyen avances (aunque algunos son sólo parciales) y retrocesos y, por último, presentamos las conclusiones y lo que consideramos falta por hacer. Los elementos vertidos en estos apartados provienen de la experiencia y reflexiones de los integrantes de un equipo evaluador (EE) que ha efectuado más de 30 evaluaciones de programas sociales federales de 2001 a 2016, así como de la información proporcionada por miembros de otros EE en las reuniones formales con el Coneval o informales con la autora.

Evolución de la evaluación

En su portal, el Coneval define a la evaluación como: “[...] el análisis sistemático e imparcial de una intervención pública cuya finalidad es determinar la pertinencia y el logro de sus objetivos y metas, así como la eficiencia, eficacia, calidad, resultados, impacto y sostenibilidad”.2 En La política de evaluación en México: 10 años del Coneval. la definición es diferente, pero complementaria: “[...] una acción sistemática y objetiva que genera información confiable y rigurosa sobre el diseño, implementación, resultados e impacto de la política de desarrollo social. El objetivo de la evaluación es mejorar y reorientar las acciones y programas sociales hacia el logro de resultados, esto es, a la atención de problemáticas sociales”.3

Aunque en el siglo XX hubo algunas evaluaciones,4 podemos ubicar su surgimiento como práctica sistemática a principios de este siglo, por lo que en realidad es un proceso bastante joven, pero muy difícil de sintetizar en el breve espacio que disponemos. Por ello, en el Anexo 1 presentamos una apretada síntesis de los acontecimientos más relevantes para la evaluación en México, sobre todo de los vinculados con la institucionalización de la evaluación (promulgación de leyes y otras disposiciones jurídicas, creación de instituciones e instancias y puesta en marcha de algunos programas).5

Además, es importante considerar el contexto en el que se ponen en marcha las evaluaciones en la década de 1990: i) la entrada en vigor del Tratado de Libre Comercio de América del Norte (TLCAN) en enero de 1994 y la devaluación a fines de ese año provocaron una difícil situación económica para la mayoría de la población y un incremento de las críticas sobre el uso clientelar del gasto social; y ii) las derrotas electorales del Partido Revolucionario Institucional (PRI) en 1997 (pierde la mayoría absoluta en el Congreso) y en 2000 (por primera vez el presidente de la República no procede de ese partido) que propiciaron la recuperación de los pesos y contrapesos delineados en la Constitución.

Uno de los momentos más relevantes fue la promulgación de la Ley General de Desarrollo Social (LGDS) ya que dio forma al Sistema Nacional de Desarrollo Social (SNDS) y al Sistema de Monitoreo y Evaluación (SME) basado en resultados, “el cual busca que las acciones, programas y políticas de desarrollo social se orienten hacia el logro de resultados y garanticen la transparencia y la rendición de cuentas”.6 La Figura 1 muestra el proceso que establecen los Lineamientos.7

Fuente: Coneval, La política de evaluación en México..., op. cit., p. 30, con base en los “Lineamientos generales para la evaluación de los Programas Federales de la Administración Pública Federal”.

Figura 1 Regulación de las evaluaciones

Otros elementos a tomar en cuenta son los retos que debieron enfrentarse. En La política de evaluación en México: 10 años del Coneval, esta institución indica:

[...] en la construcción del Sistema de Monitoreo y Evaluación ha sido necesario solucionar una serie de retos institucionales, técnicos y de planeación. Los retos institucionales se refieren a adecuar y cambiar las reglas del juego de los agentes involucrados para que se lleve a cabo la evaluación y se use la información. Los retos técnicos se relacionan con el desarrollo de metodologías adecuadas para evaluar de acuerdo con las necesidades: medir impactos, tener instrumentos para recolectar información pertinente y contar con evaluadores capacitados. Por último, los retos de la planeación se deben vincular para lograr un buen sistema de monitoreo con indicadores adecuados, es decir, el marco lógico de los programas. La siguiente sección examina dichos retos y cómo se han abordado en el caso mexicano.8

Sin embargo, la sección de retos institucionales sólo narra los que existían cuando surgió el Coneval y lo que se ha hecho al respecto, pero no menciona los actuales.

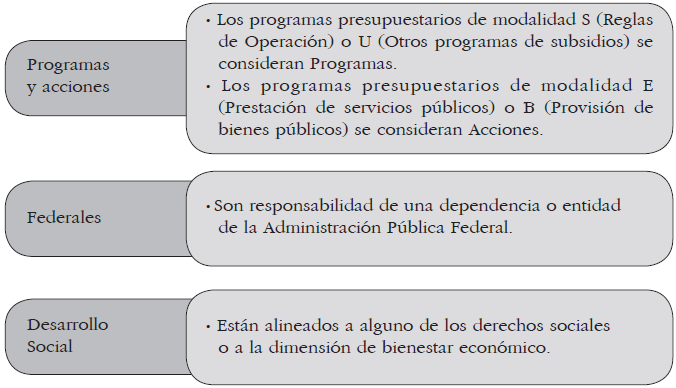

En cuanto a los retos técnicos, el Coneval indica que se ha avanzado en delimitar los objetivos de la evaluación; los actores y usuarios finales de la información (Figura 2); los programas y las acciones federales que conforman el universo de acción del Coneval y elaborar el Inventario de éstos (Figura 3) y el Horizonte de Monitoreo y Evaluación (Figura 4, véase infra).

Fuente: Coneval, La política de evaluación en México..., op. cit., p. 36.

Figura 2 Objetivos de la evaluación y usuarios

Fuente: Coneval, La política de evaluación en México..., op. cit., p. 37.

Figura 3 Programas y acciones federales de desarrollo social

Nota: la etapa 0 corresponde al periodo en el que se diseña la estrategia o programa. A partir de la etapa 1 corresponde al primer año de operación del programa.

Fuente: Coneval, La política de evaluación en México..., op. cit., p. 38.

Figura 4 Horizonte de monitoreo y evaluación

Llama la atención que en la Figura 2 no aparecen las instituciones académicas y de investigación, personas físicas o morales especializadas en la materia u organismos especializados, de carácter nacional o internacional los que, de acuerdo con los presupuestos de egresos de la Federación (PEF), son los encargados de realizar las evaluaciones. Además, las primeras han sido actores clave en la profesionalización de los EE y de los servidores públicos, así como en el enriquecimiento constante de las metodologías a aplicar y en el uso de las evaluaciones como materia prima para sus investigaciones.

Un primer problema que se deriva de la Figura 3 es que existan programas presupuestarios que se consideran acciones, lo cual resulta confuso.

Adicionalmente, a pesar de ser una publicación de 2015, la Figura 3 sólo alude a cuatro modalidades;9 empero, desde 2007 se han llevado a cabo evaluaciones a programas de otras modalidades como se observa en el Cuadro 1.

Nota: se excluyeron los documentos que no correspondían a evaluaciones (diagnósticos, opinión de la dependencia, posición institucional) o duplicaban su número (informes ejecutivos) y los que correspondían a evalauciones de más de un programa (estratégicas y marcadas con guión).

Fuente: elaboración con base en Coneval (archivo zip disponible) [http://www.coneval.org.mx/Evaluacion/Paginas/InformeEvaluacion.aspx], fecha de consulta: 20 de septiembre de 2016.

Cuadro 1 Modalidades de programas presupuestarios evaluados 2007-2016

Fuente: elaboración con base en los programas anuales de evaluación 2007-2016.

Cuadro 2 Evaluaciones ordenadas en los PAE según tipo de evaluación 2008-2016

Finalmente, la Figura 4 muestra las diferencias de actividades asociadas con el monitoreo y la evaluación.

Empero, parecería que en los únicos retos donde todavía hay que trabajar son los de planeación:

La planeación es el último reto en la construcción del Sistema de Monitoreo y Evaluación. Se refiere a contar con un sistema de monitoreo basado en resultados con indicadores adecuados. Existen problemas potenciales si no se mide lo que es relevante. Más allá de considerar únicamente el ejercicio del presupuesto y de la gestión, es indispensable medir resultados. Por ello, el reto es generar una cultura que premie el logro y no sólo el ejercicio a tiempo del recurso.10

Sin embargo, después de describir el proceso que se ha llevado a cabo para la elaboración y aprobación de las MIR y sus indicadores, concluye con una afirmación que da la impresión de que también ha sido superado:

Diseñar mejores indicadores de resultados y de gestión para los programas presupuestarios federales ha sido una tarea ardua. El objetivo es tener un sistema con los indicadores suficientes y necesarios para dar seguimiento a los objetivos de los programas de la política social, y más importante aún, que sean utilizados en la toma de decisiones.

No obstante, la realidad dista de haber superado todos estos retos y todavía se requiere un gran esfuerzo de capacitación a los servidores públicos para que generen indicadores que reflejen adecuadamente los avances en el logro de resultados.

En las conclusiones, el Coneval señala algunos retos actuales, con los cuales coincidimos:

Expandir la oferta de evaluadores de calidad.

Crear sistemas de monitoreo y evaluación en las entidades federativas y municipios que faciliten su comparabilidad.

Lograr una vinculación más estrecha entre el proceso de medición de problemáticas nacionales, de evaluación y el proceso de presupuestación.

Transitar a la evaluación de los objetivos nacionales, así como de su medición efectiva.11

Avances

Además de los avances indicados anteriormente y en el Anexo 1, los evaluadores percibimos otros que van desde la contratación de las IE hasta los contenidos y usos de los informes:12

Acceso a los informes de las evaluaciones. En el portal del Coneval se puede descargar una base de datos en archivo zip en el que se encuentran los vínculos a todos los documentos13 relacionados con las evaluaciones de 2007 a 2016 (aunque la captura no es uniforme14 y contiene muchos errores que dificultan el uso de los filtros y, en general, la búsqueda).

Adquisición de experiencia por parte de las DE. A pesar del constante cambio de personal, las DE tienen más claro el proceso desde la contratación de las IE hasta aceptar las recomendaciones y conclusiones de la evaluación, convertirlas en aspectos susceptibles de mejora (ASM), mejorar sus matrices de indicadores para resultados (MIR) e indicadores y, sobre todo, en la operación de los programas y la obtención de resultados.

Mayor cultura de evaluación. Ahora se comprenden más las diferencias entre auditorías y evaluaciones, y los resultados de estas últimas son cada vez más conocidos (y usados) por los servidores públicos, los diputados y la ciudadanía. Sin embargo, como señalan Pérez, Maldonado y Hernández: “La práctica de la evaluación estuvo principalmente vinculada a lo simbólico más que a lo conceptual e instrumental”,15 y aún hoy no son un mecanismo real de rendición de cuentas horizontal ni de mejora de todos los programas evaluados.

Mejor calidad de la información disponible. La información proporcionada por las UROP suele ser más completa y de mejor calidad, aunque las bases de datos siguen teniendo problemas de captura (con y sin tilde, con y sin abreviaturas, errores de tipeo y celdas vacías).

Mejor conocimiento del mercado. Las UCE pueden ahora revisar las características de los informes de las IE, la objetividad y seriedad con que los elaboran, así como la puntualidad con la que los entregan, por lo cual pueden hacer una mejor selección. Por su parte, las IE tienen a su disposición el resultado de las evaluaciones realizadas desde 2007: lo que se ha pagado por estudios similares, cómo se ha respondido a ciertas preguntas que no son del todo aplicables a algunas modalidades,16 qué metodologías de campo han utilizado, etcétera.

Periodicidad de las evaluaciones. De 2000 a 2006 las evaluaciones fueron anuales, pero -dados los tiempos institucionales para realizar la programación, presupuestación, ejecución y evaluación- la mayoría de las recomendaciones no se aplicaban antes de la siguiente evaluación. A partir de la publicación de los PAE se han espaciado: la mayoría de los programas tuvieron ECR en 2007, 2011-2012 y el PAE las ordenó a 19 programas en 2016, a ocho las de procesos, y a 152 las fichas de monitoreo y evaluación -aunque estas últimas son elaboradas internamente por las unidades de evaluación (UE) de las dependencias y entidades (DE) a cargo de los mismos y no son realmente evaluaciones.

Profesionalización y mayor capacidad técnica de los equipos evaluadores. Además de la mayor exigencia de los términos de referencia (TR), hay mayor literatura disponible relacionada con la metodología del marco lógico y de las evaluaciones, cursos de capacitación y diplomados, así como acceso a información en internet (independientemente de la proporcionada por la UROP) como los informes de cuenta pública, analíticos del presupuesto, lineamientos o reglas de operación de los programas, por mencionar solo algunos.

Requisitos que deben cubrir las IE más elevados y específicos. Los TR especifican la formación y el perfil de los “puestos” dentro del EE (p. ej., el coordinador de la evaluación debe contar con doctorado y tres años de experiencia en evaluaciones) y la incorporación de ciertos especialistas (un ingeniero o arquitecto para la verificación de la calidad de las obras). Durante estos años, las características que se solicitan se han elevado y, en 2016, la sección Requisitos mínimos académicos y de experiencia esperados de cada uno de los integrantes clave del EE de los TR contenía los cargos (coordinador, coordinador técnico-operativo, coordinador de trabajo de campo, asesores, consultor especializado en estadística, investigador, asistente de investigación, etcétera), los requisitos académicos (licenciatura o posgrado en determinadas ciencias o disciplinas), la experiencia general (en evaluaciones o en investigación de programas gubernamentales o temas relacionados con el programa a ser evaluado) y experiencia específica (análisis de programas gubernamentales, MIR, indicadores, etcétera), dadas las particularidades del programa y el tipo de evaluación solicitada.

Selección de las IE considerando la especificidad de las evaluaciones. Hasta 2005, la Ley de Adquisiciones, Arrendamientos y Servicios del Sector Público (LAASSP) obligaba a elegir la opción de menor monto y limitaba la posibilidad de elegir la mejor propuesta técnica. A partir de la reforma de ese año17 se establece la evaluación de las propuestas por el mecanismo de puntos y porcentajes considerando los siguientes rubros y rangos: experiencia y especialidad de 10 a 25; capacidad de 10 a 30; integración de la propuesta de 40 a 55 y cumplimiento de contratos de 0 a 10. Asimismo, establecía un índice de ponderación técnico-económico con el que se determinaba la proposición solvente que sería susceptible de ser adjudicada con el contrato, por haber cumplido con los requisitos exigidos y cuyo resultado fuera el de mayor puntuación. Así, la propuesta económica menor sólo tendría garantizada 50% de la puntuación, pero requería alcanzar un mínimo de puntos en la parte técnica.

La LAASSP vigente ya no incluye los rubros y rangos de los porcentajes,18 pero estipula que:

Artículo 29. La convocatoria a la licitación pública, en la cual se establecerán las bases en que se desarrollará el procedimiento y en las cuales se describirán los requisitos de participación, deberá contener:

[...] XIII. Los criterios específicos que se utilizarán para la evaluación de las proposiciones y adjudicación de los contratos.

Además, indica que se prefiera ese mecanismo (y, en algunos casos,19 su obligatoriedad).

Uniformidad de las evaluaciones. En general, se contestan las mismas preguntas, de la misma forma (binaria y argumentación) y con los mismos criterios,20 aunque existen algunas diferencias en los TR de la SHCP y del Coneval.

Avances parciales

Análisis de factibilidad para llevar a cabo una evaluación de impacto. Las evaluaciones de impacto pueden hacerse sólo después de que un análisis de factibilidad demuestre que el programa cumple con:

[...] una serie de requisitos del monitoreo de información necesaria para llevarla a cabo [...] Este documento debe ser presentado por la dependencia o institución a cargo del programa y será analizado por el Coneval21 [...] A partir del análisis de este documento se emitirá una opinión sobre la factibilidad de llevar a cabo la evaluación de impacto, o en su defecto realizar otro tipo de evaluación de seguimiento de resultados.22

No obstante, en el portal del Coneval no existe uno solo de estos estudios en todas las evaluaciones de impacto efectuadas, por lo que no se puede constatar el cumplimiento de esta disposición.

Dificultad para consultar los principales documentos relacionados con las evaluaciones. Hace algunos años, el portal del Coneval contaba con una sección donde se podían consultar los diferentes documentos relacionados con las evaluaciones (modelos de términos de referencia, Programas Anuales de Evaluación, etcétera). En 2016, la normateca contiene más disposiciones del propio Coneval que de aquellos y el listado está desactualizado23 (además de estar mal ubicado, pues se encuentra dentro del vínculo a la normatividad interna).

Seguimiento de los ASM. El mecanismo para este seguimiento fue emitido en 2008 para asegurar la utilidad de las evaluaciones pues ordena que las UE, las áreas responsables de la operación, la programación y la presupuestación de los programas u otras unidades de las DE analicen las evaluaciones externas y elaboren un documento de trabajo para cada programa y un documento institucional por dependencia, en el que se especifique qué acciones se implementarán para mejorar el programa o las políticas, a raíz de los resultados relevantes de las evaluaciones externas. Cada dependencia elabora estos documentos con entera libertad y están disponibles en su página de internet desde el 31 de enero de 2009.24 En las evaluaciones externas subsiguientes se verificará que el programa haya tenido avances y mejoras.

Los objetivos específicos del mecanismo son:

Establecer el proceso para el seguimiento a recomendaciones de evaluaciones externas para hacer efectivo el uso de los hallazgos de las evaluaciones en la mejora de los programas y políticas.

Definir los responsables de establecer los instrumentos de trabajo para dar seguimiento a los aspectos susceptibles de mejora, así como para la formalización de los mismos.

Definir las fechas de entrega de los documentos de seguimiento a los aspectos susceptibles de mejora.

Analizar los documentos de seguimiento y la incorporación de las recomendaciones requeriría un artículo completo. Sin embargo, podemos puntualizar aquí las observaciones más importantes:

En el archivo zip del Coneval mencionado se encuentran los vínculos a todos los documentos25 relacionados con los ASM derivados de las evaluaciones de 2007 a 2015, aunque hay problemas de uniformidad26 en la captura que dificultan la consulta y localización de los documentos. Adicionalmente, no se incluye la información del tipo de evaluación que dio origen a esas recomendaciones por lo que -para determinar qué programas no reportaron ASM ni asumieron ningún compromiso de mejora- habría que abrir cada documento de posición institucional y localizar los párrafos dentro del texto, para después elaborar un cuadro por programa y tipo de evaluación (e, incluso, modalidad presupuestaria).

En dicho archivo existen 1 685 registros clasificados como Seguimiento a recomendaciones, de los cuales 197 son documentos institucionales27 (uno por dependencia), por lo que habría 1 488 documentos de ASM de programas y, de éstos, 774 son documentos de trabajo,28 por lo que los documentos que efectivamente analizan qué recomendaciones van a atender serían sólo 714. Esta cifra se eleva a 813 si tomamos en cuenta los documentos de trabajo de 2015 ya que de ese año no existen institucionales. De una manera más general, si comparamos el Cuadro 1 con el Anexo 1 podemos constatar que de las 38 DE que han tenido evaluaciones, 17 no han dado seguimiento a las recomendaciones o no han entregado al Coneval algún documento al respecto.

Lo más grave es que en los diferentes tipos de documentos institucionales se comentan las recomendaciones y muchas de ellas simplemente se descartan por considerarlas “improcedentes”, “no factibles”, “ambiguas”, “inadecuadas”, etcétera, o descalificando la evaluación,29 sin que haya ninguna instancia que las revise u observe.

Por último, no hay ningún mecanismo para verificar que realmente se hayan realizado las mejoras (de las pocas recomendaciones aceptadas por las DE) y entregado en tiempo y forma los productos comprometidos. Salvo las modificaciones a las reglas de operación (que se pueden consultar en el DOF para el siguiente ejercicio fiscal) ni los evaluadores ni la ciudadanía en general pueden constatar que realmente hayan sido atendidos los aspectos susceptibles de mejora.30

Nota: tómese en cuenta que en muchos casos los informes finales se concluyen durante el siguiente ejercicio fiscal, por lo que los ASM pueden corresponder a evaluaciones del año previo.

a En este año no están disponibles los documentos de posición institucional, por lo que se consideraron los de trabajo.

Fuente: elaboración con base en Coneval [http://www.coneval.org.mx/Evaluacion/Paginas/InformeEvaluacion.aspx], fecha de consulta: 9 de abril de 2017.

Cuadro 3 Seguimiento de los ASM según dependencia o entidad 2007-2015

Retrocesos31

Actitud irrespetuosa de las UCE y las UROP hacia los equipos evaluadores. No siempre ha sido bien recibida la presencia de la evaluación externa y se han exteriorizado varios tipos de actitud irrespetuosa, de los cuales mencionamos sólo unos cuantos ejemplos:

El Oficial Mayor de una entidad les dijo a las UROP que sólo le dieran “el avión” al EE porque no tenían ninguna obligación de tomar en cuenta las conclusiones o seguir las recomendaciones a las que aquél llegara.

La UROP de una entidad dio cifras equivocadas durante toda la evaluación y proporcionó las correctas la víspera de la entrega del informe final, argumentando que las cifras definitivas sólo se obtenían cuando se terminaba el reporte de la cuenta pública.

Una dependencia amenazó al evaluador con no pagarle lo convenido si no modificaba las conclusiones, corrigiendo las calificaciones que el programa había obtenido.

Un EE fue vetado por el titular de una UROP en la elección de instancias a invitar al concurso ya que lo coordinaba una mujer y no le iba a resultar fácil llevarla a una cantina para negociar las conclusiones de la evaluación (como acostumbraba).

En los primeros años de este sexenio, el número de evaluaciones ordenadas por los PAE se redujo drásticamente, así que algunas DE aprovecharon la situación para tener un trato despótico y arbitrario hacia los EE incluso señalando “y si no les gusta, váyanse, hay muchos equipos que no consiguieron ninguna evaluación”.

Falta de transparencia. Muchas evaluaciones no contienen el Anexo con los datos del evaluador, la forma en que se asignó y el costo del estudio. En el índice del documento elaborado por la dependencia, muchas indican “lo llena el Coneval”, pero no se sabe si eliminan la ficha que el evaluador llenó (y no lo sustituyen por una completada por el Coneval) o la UCE no tuvo cuidado de exigir a la IE la entrega completa de los Anexos solicitados en los términos de referencia.

Además, en el portal del Coneval sólo están los vínculos a las evaluaciones ordenadas en los PAE, pero no otros tipos de estudios contratados, aunque el propio Coneval indica:

Asimismo, con el fin de mostrar a la ciudadanía la información sobre el desempeño de las dependencias y entidades, en los programas federales se establece la obligación de dar a conocer de forma permanente, a través de sus respectivas páginas de internet, los documentos y resultados de todas las evaluaciones.32

Por último, en aras de uniformar la presentación, algunas DE insertan su logo en el informe final, lo que les resta credibilidad a los resultados del estudio. Además, puede generar suspicacias acerca de si es lo único que modificaron o si se respetaron los documentos tal como fueron entregados por los evaluadores.

Inventario federal de programas y acciones federales de desarrollo social (Inventario Coneval).33 De acuerdo con el documento Presentación y Análisis del Inventario 2014-2015:34

La información del Inventario Federal está organizada de forma estructurada y clasificada por apartados con la finalidad de facilitar su consulta y el análisis de los datos. Ésta se puede clasificar en siete apartados generales que se describen a continuación:

1. Datos generales: ramo y dependencia a la que pertenece, modalidad y clave presupuestal, año en que fue creado, datos de contacto del responsable titular y otros datos que permiten identificar de manera general el programa.

2. Derechos y objetivos: derecho social o dimensión de bienestar económico directo o indirecto, objetivo general, problemática o necesidad que atiende; principal normatividad y su vínculo electrónico y resumen narrativo de la MIR, entre otras.

3. Población: potencial, objetivo y atendida; definición, unidad de medida y cuantificación; etapa de vida, grupos y ámbitos de atención; requisitos, tipos de apoyos que entrega y existencia de padrón de beneficiarios.

4. Presupuesto: original, modificado y ejercido.

5. Evaluación: evaluaciones en el ejercicio fiscal 2014; elementos técnicos de la evaluación y vínculos a las bases de datos de evaluaciones que realizaron trabajo de campo.

6. Aspectos Susceptibles de Mejora (ASM): vínculos a los documentos de trabajo e institucionales de los ASM 2014-2015.

7. Porcentaje de información entregada por programa con respecto al total de variables que integran el Inventario 2014.35

Con todo, existen varios problemas:

Esto fue válido sólo de 2009 a 2012 (111 variables), 2013 (118 variables) y 2014 (120 variables).

Aunque el nombre de la publicación citada indica 2014-2015, advierte “dada la información disponible, los análisis se concentran entre 2008 y 2014”.

La consulta en línea teóricamente se puede hacer para 2009-2014 con cinco opciones: criterios de búsqueda, por derechos y objetivos, beneficiarios, evaluación y presupuesto, pero frecuentemente arroja “cero resultados” y sólo se obtienen resultados en la pestaña de presupuesto (ciclo, ramo, institución, entidad y unidad responsable), es decir, ¡no indica el nombre del programa ni el presupuesto!

Para 2015 y 201636 está disponible un listado que se puede filtrar, pero (en lugar de las 120 variables que contenía en 2014) ahora sólo proporciona ramo, institución, entidad,37 modalidad presupuestal, clave presupuestal, nombre del programa 2016, nombre anterior del programa, año de inicio, año de operación y presupuesto original (millones de pesos), lo que significa que dejaron de capturarse (o informar de) 110 variables.

Opacidad. Gestión Social y Cooperación, AC (Gesoc) se define como un “organismo de la sociedad civil especializado en la generación de evidencia y soluciones metodológicas útiles y robustas para que las iniciativas sociales de los gobiernos maximicen el valor público que producen en favor del desarrollo social, con apego a los principios de transparencia, rendición de cuentas y respeto a los derechos humanos”.38 Gesoc ha desarrollado una metodología llamada Índice de desempeño de los programas públicos, que utiliza para estimar en una escala de 0 a 100, el nivel de desempeño de cada programa social en función de la capacidad de solucionar el problema público que atiende. Utiliza tres variables que se sustentan en información oficial públicamente disponible:

La calidad de diseño del programa

La capacidad del programa para cumplir con sus metas

La cobertura de la población objetivo

Como resultado, cada programa social se clasifica en alguna de las seis categorías de desempeño dependiendo de la calificación final que obtuvo: 1) Desempeño óptimo. 2) Alto potencial de desempeño. 3) Desempeño mejorable. 4) Desempeño escaso. 5) Programas que reflejan la dispersión de la política social federal. 6) Opacos (caja negra del gasto social federal).

Como se observa en el Cuadro 4, en 2013 había 44 programas opacos (26.04%) que absorbían 13.31% del presupuesto.

Fuente: Cámara de Diputados, Comisión Especial de Programas Sociales, “Análisis del documento ‘Índice de desempeño de programas públicos federales (Indep) 2013’, elaborado por Gestión Social y Cooperación, A.C.”, 21 de noviembre de 2013.

Cuadro 4 Programas y presupuestos por nivel de desempeño, 2013

En 2014 aumentaron los programas ubicados en la caja negra ya que 34.6% de los programas y acciones federales de desarrollo social (63 de 182) presentaron problemas de opacidad que impiden estimar su desempeño39 y esta cifra se incrementa a 77.5% (141 programas) si añadimos los que “no tienen posibilidad alguna de resolver el problema público que atienden debido a la dispersión programática y presupuestal que presentan”.40

En 2015, un programa disminuyó su opacidad (con respecto a 2013), pero aumentaron 14 los que muestran dispersión, como se aprecia en el Cuadro 5.

Fuente: “Índice de desempeño de los programas públicos (Indep) 2015. Resumen ejecutivo” [http://www.indep.gesoc.org.mx/files/Resumen_Ejecutivo_INDEP_2015.pdf].

Cuadro 5 Programas y presupuestos por nivel de desempeño, 2015

No obstante, es importante hacer hincapié en que el número de programas evaluados difiere en cada uno de los tres años (169 en 2013; 182 en 2014 y 161 en 2015) y que no está disponible el cuadro para 2014, por lo que debe tomarse en cuenta la participación relativa de cada categoría y sólo de la información referida en el texto de 2014. Así, puede decirse que entre 2013 y 2014 la participación relativa de los opacos más los dispersos pasó de 45.6 a 77.5% con una participación mayor de los opacos en ambos años (26.04% en 2013 y 42.9% en 2014).

En otras palabras, en 2014 (22.5%) un menor porcentaje de programas se ubicaba en las cuatro primeras categorías (Óptimo, Alto potencial, Mejorable y Escaso) (frente a 54.4% en 2013) pero con una leve recuperación en 2015, ya que 44.1% de los programas estarían en las categorías de mejor desempeño con una mayor participación de los dispersos (29.2%) que los opacos (26.7%) que podría significar un mejoramiento de los “caja negra” al acercarse a su participación relativa de 2013, así como de los que están en las mejores categorías de desempeño (44.1% en 2015 frente a 22.5% en 2014 y 54.4% en 2013).

Selección de las IE. Si bien en el segundo apartado se consideró un avance que a partir de 2005 se estableciera la evaluación de las propuestas por el mecanismo de puntos y porcentajes, en la práctica las DE han encontrado mecanismos para hacer las cosas “a su manera”:

Solicitan cotizaciones o estudios de mercado, pero después no invitan a las mismas IE al concurso ni informan a quién se adjudicó ni con base en qué criterios (o, en todo caso, si no se llevó a cabo el estudio y porqué).

No se informa del calendario completo y, cuando se da una fecha de fallo, no se cumple y no se notifica la causa del retraso ni de la nueva fecha en la que se comunicará el resultado.

Han creado una modalidad nueva (la lista corta),41 no prevista en la LAASSP, con la cual todas las ventajas son para los contratantes y no se respetan los procedimientos de dicha ley.

Cuando la evaluación de las propuestas se lleva a cabo por el mecanismo de puntos y porcentajes, se ha presentado una gran subjetividad en la valoración de los rubros no cuantitativos (experiencia del equipo, aspectos técnicos de la propuesta, bibliografía preliminar, etcétera).42

Términos de referencia. En un primer momento, la creación del Coneval, la emisión de los Lineamientos y los programas anuales de Evaluación lograron cierta uniformidad de las evaluaciones y de los requisitos de las IE, pero después de unos años, nuevamente se presentaron diferencias:

Cada entidad coordinadora43 tiene su propio modelo de TR argumentando que se trata de “diferentes instrumentos de evaluación de acuerdo con los objetivos que persigan, a partir de los cuales los actores hacen distintos usos de la evaluación para cumplir sus responsabilidades”.44

Requisitos innecesarios o inadecuados en los TR (número y características de los integrantes del EE, tiempo de experiencia, etcétera).

Falta de especificación en los TR del contenido y presentación de las entregas.

Conclusiones

En menos de dos décadas se han logrado avances indiscutibles en el proceso de evaluación que van desde la contratación de las instancias evaluadoras (IE) hasta los contenidos y usos de los informes. A pesar de ello, subsisten muchas interrogantes: ¿cómo se van a atender las funciones que la SFP desempeñaba en el proceso de evaluación?, ¿no ha cambiado la situación en los diez años de existencia del Coneval?, ¿no surgen nuevos retos al dejar de funcionar tres coordinadoras y, a partir de 2016, sólo dos?, ¿están resueltos todos los aspectos de coordinación entre la SHCP y el Coneval?

Aunque no es el propósito central del artículo, cabe señalar algunas recomendaciones ya que hay aspectos de mejora en el proceso de evaluación que incrementarían la transparencia y la utilidad (y uso) de los resultados:

Establecer una definición de los programas sujetos a reglas de operación.45

Avanzar más aceleradamente en la incorporación de las evaluaciones, los ASM y el PbR en los gobiernos subnacionales.

Crear una sección en el portal del Coneval que incluya los distintos tipos de TR utilizados por las dos coordinadoras (Coneval y SHCP), distinguiéndolos por entidad coordinadora, tipo de evaluación y modalidad del programa presupuestario, ya que tienen ligeras diferencias y no es fácil localizarlos.

Incluir en los retos institucionales los relacionados con las DE y no sólo con las coordinadoras. Así, tendrían que preverse mecanismos permanentes para resolver los constantes cambios de personal en aquéllas y la falta de una memoria institucional sobre cada programa. Las dos coordinadoras (o de preferencia sólo el Coneval) deberían poner a disposición del público en general los documentos que dan origen a la creación de cada programa (justificación, diagnóstico, cuantificación de sus poblaciones potencial y objetivo, etcétera, así como los rediseños que cada uno haya presentado).46

Disminuir los programas opacos e incrementar el número de los que se encuentran en las primeras categorías de desempeño.

Crear una instancia que garantice el seguimiento de los ASM y verifique el cumplimiento (y la calidad) de los compromisos adquiridos.

Concentrar la documentación pública relevante de cada programa (diagnóstico, reglas de operación, medición y actualización de las poblaciones potencial y objetivo, evaluaciones, ASM, etcétera) en una sola página permanente y de forma uniforme entre las dependencias y entidades.

Facilitar el acceso al público sobre los motivos por los cuales se crea o desaparece un programa o se modifica drásticamente su presupuesto.

Por último, conviene señalar que, aunque de 2002 a 201747 estuvo vigente la Ley Federal de Responsabilidades Administrativas de los Servidores Públicos, no está prevista ninguna sanción explícita para los servidores públicos que entorpecen las evaluaciones.48 Por su parte, la Ley Federal de Presupuesto y Responsabilidad Hacendaria incluye un capítulo sobre la evaluación, pero está más preocupada por elementos de corrupción y malversación de fondos y remite a la otra ley para las sanciones. Por lo anterior, convendría pensar no sólo en sanciones sino en mecanismos o instancias que garanticen el cumplimiento de las disposiciones aplicables.

En 200849 señalamos que el Poder Legislativo ejerce un contrapeso sobre el Ejecutivo (modificando el presupuesto que éste envía o desapareciendo por completo el asignado a un programa específico) mas no es aún una relación de rendición de cuentas (RC) en tanto que ni el público en general, ni las UROP ni las IE reciben información suficiente acerca de las razones que sustentan la modificación de la propuesta del Ejecutivo. Hoy esto sigue siendo válido, empero, en los siete supuestos que entonces analizamos para determinar si se trataba de una RC horizontal (independencia de la evaluación, ética de los evaluadores, disposición de la UROP, calidad y oportunidad de la información, contenido apropiado de las evaluaciones, calidad de las evaluaciones e incidencia en las políticas públicas) existen avances alentadores, pero aún falta camino por recorrer.

En particular, coincidimos con los cuatro desafíos que señalan Gabriela Pérez, Claudia Maldonado y Domingo Hernández: i) que se conforme una dimensión interna de aprendizaje y de orientación a la mejora de los programas y de las propias evaluaciones; ii) la información no se transmite, comunica ni traduce automá ticamente en procesos de mejora, control ciudadano o aprendizaje de política pública; iii) la calidad y la heterogeneidad de las evaluaciones afecta naturalmente la capacidad de apropiación del proceso y los resultados de la evaluación, y iv) normalización centralizada de metodologías, términos de referencia y ciclo de evaluación en función del ciclo de vida de los programas.50

nueva página del texto (beta)

nueva página del texto (beta)