Introducción

Es cada vez más común que las comunidades científicas reconozcan la relevancia para su desarrollo profesional que tiene el adquirir habilidades para comunicar su trabajo a públicos externos a la ciencia. (Massarani, 2018; Mercer-Mapstone & Kuchel, 2016; Oliveira et al., 2019; Orozco, 2018; Pham, 2016) Sin embargo, en la mayoría de las carreras científicas esto no aparece como parte de los planes de estudio, (Mercer-Mapstone & Kuchel, 2015, 2016; Varner, 2014), pese a que las propias comunidades reconocen no contar con las herramientas y entrenamiento suficientes para hacer un buen trabajo de comunicación (Rosen & Cortassa, Documento de trabajo, sin publicar). Esto hace que los académicos vayan “a ciegas”, guiados por sus instintos y talento, al momento de comunicar su trabajo en formato divulgativo.

Nosotras alegamos que no es necesario que los científicos sean profesionales de la comunicación para dejar de “ir a ciegas” al comunicar claramente su trabajo a un público no especializado. Diversas propuestas de capacitación han surgido como parte de la expansión de la Comunicación Pública de la Ciencia (CPC), pero poco se ha discutido sobre su impacto en lo que pretenden mejorar: la habilidad para comunicar.

Una revisión profunda de la literatura en el tema revela que actualmente no hay un consenso en las características que deben tener estos cursos y talleres: ni en la duración recomendada (desde una sola sesión de 2 horas hasta un programa de 6 meses), los temas vistos (teoría de CPC, estrategias para comunicar, etc.), los materiales dados (p. ej. hojas resúmenes de las sesiones) o los grupos objetivo (p. ej. investigadores jóvenes, estudiantes de pregrado, etc.) (Bankston & McDowell, 2018; Luna & Bering, 2020; McPhetres, 2019; Mercer-Mapstone & Kuchel, 2015, 2016; Miller et al., 2009; O’Connell et al., 2020; Oliveira et al., 2021, 2019; Ponzio et al., 2018; Rodgers et al., 2018; Silva & Bultitude, 2009; Spektor-Levy et al., 2009). Es decir, también quienes diseñan e imparten estos talleres corren el riesgo de “ir a ciegas”.

Este problema ha sido planteado por la literatura, con la propuesta de escalas de evaluación de estos cursos y talleres. El problema, de nuevo, es que cada una tiene distintos parámetros para medir la “efectividad” de la intervención (Jensen & Gerber, 2020; O’Connell et al., 2020; Rodgers et al., 2018, 2020; Rubega et al., 2020; Sánchez-Mora & Macías-Nestor, 2018; Ziegler et al., 2021). Estas diferencias dificultan el diseño de un marco de evaluación, lo que impide comparar entre cursos para encontrar las mejores estrategias de capacitación y así evitar ir a ciegas en su diseño.

Algo en lo que sí hay consenso es que los parámetros que se usan para evaluar deben estar directamente relacionados con los objetivos de la capacitación (una idea que en el campo de la pedagogía probablemente resulte demasiado obvia). Es decir, al momento de elegir los objetivos (por ejemplo, claridad) se debe elegir también la forma en la que se medirán los objetivos (por ejemplo, una encuesta al público en donde califique la claridad del mensaje según determinados indicadores) (Barel-Ben David & Baram-Tsabari, 2020; Jensen & Gerber, 2020).

Para ayudar a arrojar luz sobre este problema, en esta investigación se puso a prueba una metodología para diseñar y evaluar un taller de capacitación en comunicación de la ciencia que tuvo como objetivo mejorar las habilidades de los participantes para planear y dar una charla de divulgación científica.

Con base en una búsqueda bibliográfica, se identificaron las características de una charla de divulgación científica para seleccionar temas a enseñar (p. ej. uso de recursos audiovisuales) y cómo evaluarlos. Además, se buscaron estrategias educativas para enseñar y evaluar estos temas (p. ej. tareas, ejercicios de clase) con la finalidad de incorporarlos al taller.

La evaluación se llevó a cabo a cabo en dos niveles: 1) la calidad de las charlas resultado del taller (vinculada a las características identificadas de una charla) y 2) la calidad del taller en términos de su capacidad para enseñar las habilidades para dar esas charlas (basada en la calidad de las tareas, etc.).

El taller de 8 horas se impartió a un grupo de académicas y académicos del Instituto de Fisiología Celular (IFC) de la Universidad Nacional Autónoma de México (UNAM), y su resultó en un ciclo de charlas que se transmitió por Facebook Live a través de la cuenta del IFC.

La evaluación de la capacitación es resultado de la combinación de dos metodologías: el Modelo Kirkpatrick (Barel-Ben David & Baram-Tsabari, 2020), que propone cuatro categorías de análisis (es decir, qué evaluar), y el Marco de Evaluación Triangular de Rodgers ( Rodgers et al., 2018), que propone que la evaluación provenga de tres grupos de personas distintas (capacitadora, participantes y público). Se propone un esquema de evaluación que combina ambas metodologías en donde se describe con qué instrumentos y de qué grupos obtener la información correspondiente a cada categoría.

Método

Diseño del temario y elección de recursos

Atendiendo la sugerencia de Jensen de considerar la evaluación al momento de planear cualquier producto o actividad de CPC, se diseñó una tabla delimitando los objetivos del taller y los indicadores de evaluación para cada uno de ellos (Jensen & Gerber, 2020; Varner, 2014).

A pesar de que el taller no es un producto de CPC en sí, se decidió usar el mismo enfoque porque consideramos que puede resultar útil para el diseño y posterior evaluación de capacitaciones en CPC.

Los objetivos del taller fueron:

1. Ampliar el conocimiento y sensibilizar en el tema de la CPC a las y los participantes. 2. Que los participantes conozcan algunos principios para planear y dar una charla de divulgación.

3. Que las y los participantes usen las herramientas y conceptos compartidos durante el taller en la planeación y exposición de una charla de divulgación científica.

Teniendo estos objetivos como referencia, se delimitaron temas y subtemas que ayudaran a cumplirlos (es decir, un temario) y después se buscaron herramientas que pudieran ayudar a enseñar esos temas. En este contexto, “tema” se entiende como una sección o área de conocimiento a enseñar en el taller, y “herramienta” como las actividades y materiales que ayudan a enseñar los distintos temas.

El temario del taller se diseñó con base en una búsqueda bibliográfica de talleres y cursos que se han hecho con objetivos similares, y con base en experiencias previas dando talleres similares. Se identificaron artículos que reportan resultados de capacitaciones en CPC y que propongan parámetros de evaluación o un nuevo diseño de capacitación, o bien que hablan sobre la percepción y capacitación en CPC por parte de la comunidad científica. Esto con el objetivo de encontrar qué temas, herramientas y estrategias han sido útiles para lograr sus distintos objetivos de enseñanza e incorporarlos en este taller.

Dentro de las herramientas elegidas se encuentran “materiales de apoyo” para revisar fuera de las sesiones, ya que varios estudios sugieren que esto ayuda a mejorar el aprendizaje de los temas (Bankston & McDowell, 2018; Mercer-Mapstone & Kuchel, 2016; Miller et al., 2009). Además, se optó por dejar tareas enfocadas en el diseño de la charla final.

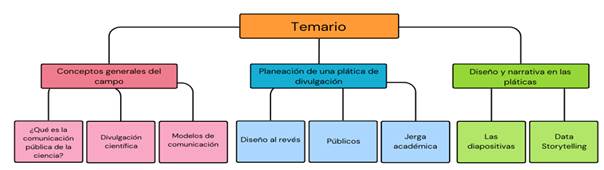

A manera de resumen se hizo la figura 1 en donde se incluyen los temas del taller:

Reclutamiento de participantes

El taller estuvo dirigido a estudiantes de posgrado, técnicos académicos, investigadores e investigadores y postdoctorantes del IFC. Se optó por incluir a personas de distintos niveles académicos y áreas de estudio porque hay alguna evidencia de que esta diversidad (sobre todo entre estudiantes de posgrado e investigadores) mejora la adquisición de habilidades comunicativas (Barba et al., 2019; Besley et al., 2015; Mercer-Mapstone & Kuchel, 2016; Oliveira et al., 2021; Ponzio et al., 2018).

Para lograr una representación de los distintos niveles académicos (estudiantes de posgrado, investigadores postdoctorales, técnicas(os) académicas(os) e investigadores), áreas de estudio y género, se eligieron a 8 personas de las 28 que se inscribieron. Sin embargo, la única investigadora inscrita se dio de baja del taller después de la segunda sesión, por lo que se terminó impartiendo el taller a 7 personas.

El taller se impartió a través de la plataforma Zoom entre el 22 de marzo y el 26 de abril de 2022 y consistió en 4 sesiones (3 teóricas y 1 práctica) de aproximadamente 2 horas cada una. Las presentaciones finales se transmitieron por Facebook Live a través de Zoom.

Evaluación

Como se mencionó previamente, se buscó la evaluación de las charlas en sí y de la capacitación de la cual resultaron éstas. Para ello, se hizo una adaptación y combinación de dos metodologías de evaluación, que se describen a continuación.

Uno de los modelos usados es una versión modificada del Modelo Kirkpatrick que realizaron Barel-Ben David y Baram-Tsabari (2020) para evaluar talleres de capacitación en CPC. Este modelo consta de cuatro niveles de evaluación: Reacción, Aprendizaje, Comportamiento y Resultados.

El nivel Reacción evalúa las percepciones, actitudes y observaciones de las personas que toman el taller sobre la capacitación. En Aprendizaje se mide el conocimiento que adquirieron los participantes durante la capacitación. Comportamiento evalúa el cambio “día a día” en términos de aplicación de lo aprendido tanto durante el taller (p. ej. tareas) como en la presentación final. Finalmente, en Resultados se ve el impacto del taller en términos de los objetivos y metas logradas. Los cuatro niveles son igual de importantes en cuanto a la información que proveen y se complementan para dar un panorama completo de la capacitación.

Por otro lado, siguiendo la propuesta de evaluación de Rodgers, et al. (2018) , la información necesaria para evaluar el taller provino de tres fuentes distintas: los participantes, el público que vio las charlas y la capacitadora. Se usaron cuestionarios de autoevaluación y de evaluación externa y observaciones para recolectar la información pertinente para la evaluación.

En la tabla 1 se muestra un resumen de la metodología previamente descrita.

Tabla 1 Resumen de la metodología de evaluación del taller

| Nivel | Rn Reacción | A Aprendizaje | C Comportamiento | Rs Resultados |

|---|---|---|---|---|

| Percepciones, actitudes y observaciones sobre la capacitación | Conocimiento adquirido durante la capacitación. | Aplicación de lo aprendido en el taller y en la presentación final. | Impacto del taller en términos de los objetivos y metas logradas. | |

| Observable |

|

|

|

|

| Instrumento de recolección |

|

|

|

|

| Indicador |

|

|

|

Cumplimiento de los objetivos del taller |

Nota. Cada columna corresponde a un nivel del Modelo Kirkpatrick. La segunda fila muestra las fuentes para cada nivel. Para facilidad de lectura, se asignó un color a cada grupo: azul corresponde a los participantes, verde al público que evaluó las charlas, y rosa a la capacitadora. En las siguientes filas el color usado corresponde a cada uno de estos grupos. En la tercera fila está el instrumento usado para recolectar la información necesaria para cada nivel. Los colores muestran a qué grupo se aplicó cada uno de estos instrumentos de recolección. Finalmente, la cuarta fila muestra el indicador correspondiente a cada nivel.

Para evaluar la calidad de las charlas se seleccionaron cuatro atributos: delimitación del tema, lenguaje, estructura y uso de recursos audiovisuales (AAAS, 2022; Varner, 2014). En la tabla 2 se resume lo evaluado para cada atributo.

Estos atributos fueron tomados en cuenta en el diseño del cuestionario de evaluación por parte del público y en las observaciones hechas por la capacitadora durante el taller y las presentaciones.

Tabla 2 Atributos evaluados en las charlas

| Delimitación del tema | Lenguaje | Estructura | Uso de recursos audiovisuales |

|---|---|---|---|

| Queda clara la idea central que quieren transmitir Relacionado al “¿Para qué?” del diseño al revés. Toda la presentación va ligada al mensaje central (es decir presenta información para dar sustento al mensaje central). | Queda clara la idea central que queiren transmitir. Relacionado al “¿Para qué?” del diseño al revés. Toda la presentación va ligada al mensaje central (es decir presenta información para dar sustento al mensaje entral). | La charla debe de tener una estructura lógica y coherente que permita al público comprender el tema tratado. Evitar hacer una presentación con la misma estructura que una charla académica. Es decir. Empezar con las conclusiones y terminar con los antecedentes. | Uso de figuras, imagines y videos que acompañen e ilustren la información de la presentación. Las figuras deben de ser claras (es decir sencillas de entender y de un tamaño que permita verlas a detalle). |

Nota: Delimitación de los atributos evaluados en las charlas con base en AAAS (2022).

Resultados y discusión

Delimitación del tema

Durante la primera sesión del taller se abordó el método “diseño al revés”, una propuesta de diseño de productos de CPC en donde se empieza por identificar el o los objetivos centrales a cumplir antes de diseñar el producto (Varner, 2014). Se presentó esta estrategia de planeación para facilitar la organización de los objetivos, permitiendo que su posterior evaluación sea más sencilla.

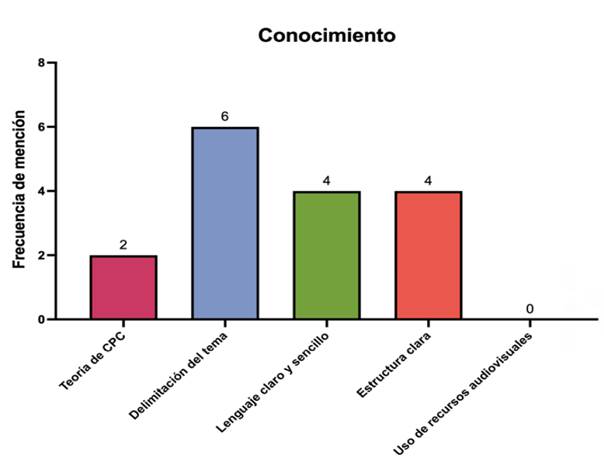

Al pedirle a los participantes mencionar de 1 a 3 cosas claves que aprendieron durante el taller, la mayoría mencionó la delimitación del tema. En la figura 2 se muestra la frecuencia de respuesta de esta pregunta abierta en el cuestionario post-capacitación.

Se clasificaron las respuestas en uno de los 4 atributos evaluados en las charlas. Se incluyó la quinta categoría “Teoría de CPC”, ya que hubo 2 personas que mencionaron temas relacionados a esto dentro de sus respuestas y no entraban dentro de las otras 4 categorías (sin embargo, sí forma parte de uno de los objetivos planteados durante el diseño del taller).

Figura 2 Conocimiento de los participantes después del taller . Nota. Sistematización de las respuestas a una pregunta abierta del cuestionario post-capacitación en donde se pedía que mencionaran de uno a tres conceptos aprendidos durante el taller.

Es importante destacar que las personas que dieron las charlas 6 y 7 (P6 y P7) fueron de las personas que mencionaron la delimitación del tema. Se resalta esto porque ambos no entregaron a tiempo las tareas relacionadas a la delimitación del tema de sus charlas, impidiendo tener retroalimentación del grupo, y fueron las charlas peor calificadas por el público.

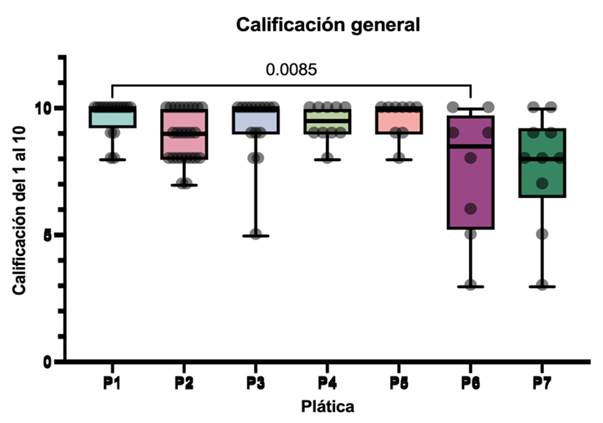

En la figura 3 se incluye un diagrama mostrando la distribución de las calificaciones dadas por el público para calificación general de las charlas. Se incluyen puntos representativos de las respuestas individuales para mayor claridad de lectura. En esta figura se puede ver que, a diferencia de las primeras cinco charlas, en las últimas dos (P6 yP7) no hay mucha consistencia en las respuestas. La caja del diagrama es mucho más grande que en las otras charlas, mostrando más dispersión en las respuestas. Esto va asociado a un promedio de calificación más bajo con respecto a las otras charlas. Es decir, las charlas que no tenían un tema delimitado y que casi no recibieron retroalimentación durante el taller resultaron en una mayor ambigüedad en la evaluación del público con respecto a aquellas que sí delimitaron su tema y entregaron en tiempo y forma las tareas del taller, permitiendo recibir retroalimentación.

Figura 3 Calificación general de las charlas. Nota. Se hizo la prueba de Tukey de comparaciones múltiples. Se muestran los valores para los cuales p<0.01.

En resumen, la delimitación del tema es un aspecto importante para el diseño de charlas de divulgación científica. Esto se observa tanto en los comentarios hechos por el público (en donde dieron una mala calificación a las charlas que no tenían un tema delimitado) como en las respuestas de los participantes (ya que la delimitación del tema fue el tema más mencionado en el cuestionario post-capacitación). Además, la retroalimentación entre y durante las sesiones ayudó a que diseñaran mejor sus charlas.

Lenguaje

Durante la segunda sesión se abordaron los distintos públicos de CPC (cómo adaptar tu charla dependiendo de a quién está dirigida) y la jerga académica (qué es y cómo evitarla). Se enseñó que una estrategia para evitar la jerga académica es el uso de metáforas y analogías, de preferencia haciendo referencia a algo con lo que se puede relacionar el público (Bullock et al., 2019; Rakedzon et al., 2017).

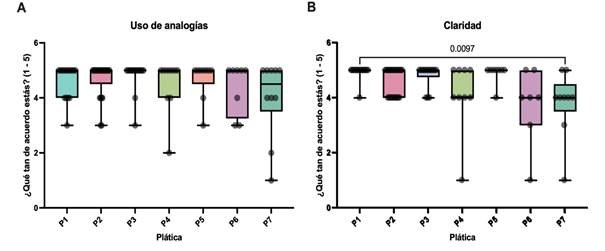

El uso de analogías fue uno de los aspectos evaluados por el público. En el panel A de la Figura 4 se muestran los resultados de la pregunta en donde se pidió al público que reportara si durante la charla se usaron analogías que ayudaron a entender los temas expuestos. En general todas las charlas fueron bien evaluadas en ese aspecto. Sigue habiendo mayor dispersión en P6 y P7 que en las otras charlas, pero esta diferencia no es significativa.

Figura 4 Uso de analogías y claridad. Notas. Se hizo la prueba de Tukey de comparaciones múltiples. Se muestran los valores para los cuales p<0.01.

P2 hizo una analogía que resultó confusa para algunas personas del público. Esto no se vio reflejado de manera negativa en la calificación de la charla, aunque sí fue algo que se mencionó frecuentemente en los comentarios del público. Esto refleja uno de los riesgos en el uso de analogías y metáforas en charlas de divulgación: deben usarse de manera cuidadosa para evitar este tipo de confusiones. Esto probablemente se pudo haber evitado con más ejercicios en donde pudieran practicar hacer analogías y metáforas para distintos conceptos.

Por otro lado, P4 sí se vio afectada en su calificación por el uso de lenguaje especializado. Esto se ve reflejado en la Figura 4. Esta charla fue la menos “divulgativa” de todas. El formato se parecía bastante al de un seminario académico tanto por el orden de la información, las figuras usadas y el lenguaje. A pesar de esto, no fue la charla peor calificada por el público, lo cual indica que el grado de especialización de la charla no era un factor determinante en su evaluación.

Esto es consistente con lo encontrado por diversos autores con respecto al uso de tecnicismos y la apreciación del público (Bullock et al., 2019; Rakedzon et al., 2017). Bullock encontró que el uso de jerga académica dificulta el procesamiento de información científica, y que este impedimento lleva a mayor resistencia motivada a la persuasión y menor apoyo para la adopción de tecnologías nuevas (Bullock et al., 2019). P4 tuvo un menor promedio y mayor dispersión de respuestas en claridad y uso de analogías. Todo esto se puede explicar por el carácter técnico de la presentación.

Quizás aquí sea importante considerar las características del público que evaluó las charlas, en particular la variable ocupación, ya que 25 personas (de 93) dijeron ser estudiantes en el área biomédica. El segundo grupo más grande fue el de personas que laboran en áreas científicas. Esto lleva a suponer que la mayoría de las personas estaban al menos familiarizadas con el contexto y quizás con varios de los conceptos presentados en las charlas. Al estar familiarizados con los temas expuestos, probablemente estaban sesgados al momento de evaluar la “claridad” de las charlas. Es decir, poder evaluar si los ponentes lograron adecuar sus charlas para que personas que no estaban familiarizadas con su tema pudieran entenderla.

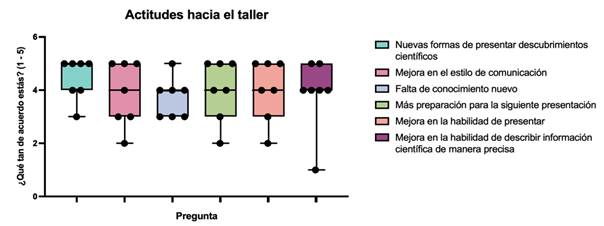

Continuando con la percepción de los participantes, estos reportaron en el cuestionario de autoevaluación posterior al taller que con las sesiones aprendieron nuevas formas de presentar descubrimientos científicos y que mejoró su habilidad para describir información científica de manera precisa, como se ve en la figura 5. P2 fue la única persona que dijo que su habilidad para describir información científica a un público no especializado no mejoró con el taller. En su comentario general sobre el taller mencionó que le hubieran gustado más actividades para reforzar el conocimiento. Esto es algo que se debe de tomar en cuenta para futuras ediciones de este taller o de otros.

En conclusión, el uso de lenguaje también fue importante para el diseño de las charlas. Tanto el público como los participantes hicieron énfasis en su importancia en las distintas evaluaciones. Las charlas que usaron lenguaje especializado o hicieron analogías confusas recibieron peores calificaciones que las que sí usaron un lenguaje claro y sencillo según la percepción del público.

Estructura

La estructura de una charla de divulgación fue explicada durante la sesión 3 del taller. Se mostró el modelo de estilo de comunicación de CPC incluido en la “caja de herramientas” de la Asociación Americana para el Avance de la Ciencia (AAAS, por sus siglas en inglés) en donde se argumenta que el público no especializado prefiere que se empiece con la conclusión en lugar de los antecedentes, como se suele hacer en ambientes académicos, ya que así se mantiene su interés durante toda la presentación (AAAS, 2022).

La mayoría de los participantes tuvo dificultades para organizar la presentación con este modelo de comunicación. Sin embargo, al momento de retroalimentarse entre ellos se dieron cuenta de que estaban cometiendo el mismo error, pudiendo identificarlo fácilmente y corregirlo para sus presentaciones finales. Esto se ve reflejado en sus respuestas en el cuestionario post taller, ya que mencionaron con mucha frecuencia que aprendieron que el orden de la información en una charla de divulgación es importante (figura 2 bajo el tema “Estructura clara”).

Probablemente les haya costado trabajo organizar la presentación de esta manera porque sólo tuvieron una sesión para entender el modelo antes de la presentación de su esqueleto. Para futuras ediciones se puede enseñar esto en alguna sesión anterior y hacer más actividades que permitan reafirmar el conocimiento.

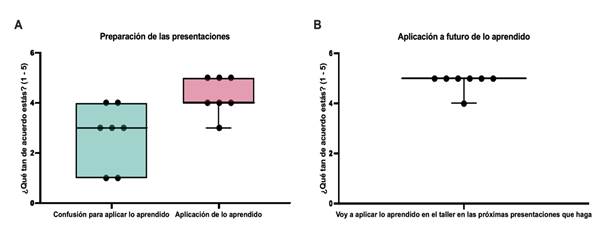

Agregado a lo anterior, en las respuestas del cuestionario de autoevaluación post-capacitación la mayoría de las personas dijeron haber usado lo aprendido en el taller en sus charlas; no obstante, también expresaron no estar muy seguros de cómo hacerlo (Figura 6A). Esto indica que durante el taller no se logró transmitir del todo cómo aplicar lo aprendido al momento de diseñar las presentaciones. Esto se puede mejorar en futuras ediciones teniendo más ejercicios prácticos o ejemplos que dejen claro cómo aplicar el conocimiento, tal y como se propuso en otros talleres similares (Ponzio et al., 2018). Por ejemplo, uno de los participantes comentó que “la información proporcionada fue buena”, aunque hubiera “querido tener algunas actividades para afianzar el conocimiento.” Por otro lado, todos los participantes dijeron que iban a usar lo aprendido en el taller en la planeación de futuras charlas de divulgación científica (Figura 6B).

El orden de la información, es decir la estructura de la charla, también fue mencionado con frecuencia por los participantes como uno de los conceptos claves aprendidos durante el taller. Este aspecto se relaciona fuertemente con la delimitación del tema, ya que en general las charlas que no lograron delimitar bien el tema tampoco tenían una estructura clara. Esto se vio reflejado en los comentarios y las calificaciones dadas por el público.

Uso de recursos audiovisuales

Ninguno de los participantes mencionó el uso de recursos audiovisuales como uno de los aspectos claves aprendidos en el taller, a pesar de que la mitad de la sesión 3 fue dedicada a hablar sobre la importancia de las figuras en las presentaciones. Se enfatizó en que usar recursos audiovisuales puede hacer que la charla sea más atractiva, y así ayudar a ilustrar conceptos complejos (AAAS, 2022). Las figuras usadas para ilustrar conceptos en un ambiente académico son distintas a las usadas en una charla de divulgación, en donde se sugiere que sean comprensibles sin tener que explicarlas. Es decir, que se entiendan por sí mismas (AAAS, 2022).

El público sí consideró los recursos audiovisuales como parte de la evaluación de las charlas. Por ejemplo, hubo charlas en las que dijeron que el material visual ayudó a entender mejor el tema, como en el siguiente comentario sobre P3:

Excelente charla, fue muy amena y clara incluso para el público que no esté familiarizado con estas ramas de estudio. Los ejemplos y el material visual que utilizó el orador lograron captar mi atención en todo momento y facilitar la comprensión del tema.

Sin embargo, no todas las personas del público estaban de acuerdo en qué constituía un buen uso de recursos audiovisuales. El más claro ejemplo de esto es P2, que se caracterizó por tener diapositivas llenas de imágenes y memes que buscaban mantener el interés del público. Hubo varios comentarios que dijeron que esto mantuvo su interés, facilitó la comprensión de los temas expuestos y permitió que prestaran atención al orador. No obstante, una persona comentó que “las diapositivas estaban muy llenas, había demasiados elementos, lo cual llegaba a distraer […]”, que contrasta con los demás comentarios.

Nuevamente esta falta de coherencia en la evaluación por parte del público es congruente con la conclusión de Rubega de que hay una falta de consenso entre el público sobre qué constituye una “buena” actividad o producto de CPC (Rubega et al., 2020). Este es un aspecto para considerar en el diseño de futuros cuestionarios de evaluación.

Todo esto lleva a que, a pesar de que el público sí considere importante el uso de imágenes al momento de calificar las charlas, no parece ser un factor determinante de la calidad ya que no afecta la calificación general de las charlas.

Síntesis de los resultados con el modelo de evaluación propuesto

El primer nivel del modelo Kirkpatrick es el de Reacción. En este se evalúan las percepciones, actitudes y observaciones sobre la capacitación.

Por un lado, los participantes mencionaron estar satisfechos con lo aprendido en el taller y con cómo se llevó a cabo, además de mencionar que les ayudaría en distintos aspectos para el futuro. En particular, hubo un participante que comentó:

Me encantó, no pensé que fuera a hacer una presentación de ese estilo, el diseño de la presentación es diferente a todas las que he hecho. Me dio seguridad de cómo hacerlo. Tengo más información incluso hasta para escribir de otra manera.

Por otro lado, también hubo buena recepción por parte del público. En general comentaron que las charlas de divulgación (y aprender a cómo hacer una) eran muy importantes tanto dentro de la comunidad científica como para el resto de la sociedad. Hubo algunas personas que mostraron interés por tomar futuras ediciones del taller. También hubo peticiones de que el ciclo de charlas se hiciera de manera recurrente y que se presentaran los resultados del presente artículo en una charla abierta al público. En conclusión, para el nivel de Reacción del Modelo Kirkpatrick el taller fue bien recibido por el público y los participantes.

El segundo nivel del Modelo Kirkpatrick es Aprendizaje, en donde se evalúa el conocimiento adquirido por los participantes durante la capacitación. En este aspecto, la mayoría de los participantes dijeron haber aprendido tanto sobre teoría de CPC como distintas herramientas y habilidades para preparar y dar una charla de divulgación científica (figura 2). Esto se vio reflejado en las evaluaciones por parte del público, en donde dieron buenas calificaciones a la mayoría de las charlas (figuras 3 y 4). Es decir, también hubo resultados favorables para el nivel de Aprendizaje.

El nivel de Comportamiento se refiere a la aplicación de lo aprendido durante el taller y en las presentaciones finales. A diferencia del nivel anterior (que evalúa lo aprendido al término del taller), en este se buscan los cambios “día a día” de los participantes en términos de aplicación de lo aprendido.

Las tareas sirvieron para ver el avance de los participantes entre las sesiones. En la mayoría de los casos se entregaron a tiempo y mejoraron tras la retroalimentación recibida tanto por parte de la capacitadora como de sus pares. Además, los comentarios que hicieron a sus pares durante la sesión 4 del taller mostraron que habían entendido lo visto en las sesiones anteriores y que podían aplicarlo para las distintas charlas que se estaban diseñando en el taller.

Durante las presentaciones por Facebook Live se vio que hicieron las correcciones pertinentes de acuerdo con los comentarios que recibieron en la cuarta sesión del taller. En estas presentaciones también se notó que las personas que no entregaron las tareas y que por lo tanto no recibieron tanta retroalimentación, tuvieron un peor desempeño, como fue el caso de P6 y P7 (figuras 3 y 4).

Por otro lado, los participantes reportaron que sí aplicarán lo aprendido durante el taller en las futuras charlas de divulgación científica que hagan (figura 6B).

Con base en todo lo anterior se puede concluir que a nivel de Comportamiento también hubo una mejora. Finalmente, el último nivel del modelo es el de Resultados. En este se mide el impacto del taller en términos de los objetivos y metas logradas.

Durante el diseño del taller se plantearon 3 objetivos: 1) ampliar el conocimiento y sensibilizar en el tema de la CPC, 2) que los participantes conozcan algunos principios para planear y dar una charla de divulgación, y 3) que apliquen las herramientas y conceptos enseñados durante el taller en la planeación y exposición de una charla de divulgación científica. Los tres niveles anteriores del modelo ayudan para determinar si estos tres objetivos fueron logrados o no.

Los resultados presentes en la figura 2 muestran que el primero de los tres objetivos se cumplió, ya que dos de los participantes mencionaron aspectos relacionados a la teoría de CPC como conceptos o ideas claves aprendidas durante el taller. Esto es congruente con los comentarios dados al inicio y final de cada sesión, en donde se recapitula lo visto hasta el momento.

La figura 2 también muestra que el segundo objetivo del taller fue cumplido, ya que los participantes pudieron mencionar correctamente distintos principios para planear y dar una charla de divulgación científica. Los comentarios dados durante las sesiones por parte de los participantes reafirman que este objetivo fue cumplido.

Las tareas, la cuarta sesión y las presentaciones finales ofrecen evidencia de que el tercer objetivo del taller también se cumplió. La mejora entre sesiones de los participantes, los comentarios hechos a sus pares y la buena retroalimentación del público muestran que lograron aplicar las herramientas y conceptos enseñados en el taller para la planeación y presentación de sus charlas de divulgación.

Conclusiones

Este artículo se propuso poner a prueba una metodología de diseño y evaluación de talleres para capacitar a científicos y científicas en la planeación de charlas de divulgación científica. Para esto, se diseñó y llevó a cabo un taller piloto a un grupo de académicos del IFC de la UNAM. Se seleccionaron cuatro atributos de una buena charla de divulgación científica: delimitación del tema, lenguaje, estructura y uso de recursos audiovisuales (AAAS, 2022; Varner, 2014).

Durante el diseño del taller se definieron 3 objetivos: 1) ampliar el conocimiento y sensibilizar en el tema de la CPC, 2) que los participantes conozcan algunos principios para planear y dar una charla de divulgación, y 3) que apliquen las herramientas y conceptos enseñados durante el taller en la planeación y ejecución de una charla de divulgación científica. Estos se usaron de base para el diseño del temario del taller.

La evaluación del taller se llevó a cabo en dos niveles: a nivel de las charlas y a nivel de la capacitación. Se compararon las evaluaciones de las charlas (tanto por parte del público como de la capacitadora) con el rendimiento de los participantes en el taller (en términos de aplicación de lo aprendido durante las sesiones), usando tanto su autoevaluación como las observaciones hechas por la capacitadora.

Con base en el análisis usando el Modelo de Kirkpatrick y comparando la información proveniente de tres fuentes de información distintas, se puede concluir que el taller logró ofrecer las herramientas necesarias a los participantes para planear y dar charlas de divulgación científica.

Pese a los buenos resultados obtenidos, la metodología de diseño y evaluación del taller presenta diferentes oportunidades de mejora.

Para empezar, en el cuestionario de evaluación del público se le pidió que reportara si percibieron que los participantes fueron claros, dominaban el tema expuesto, etc. Este tipo de evaluaciones pueden generar problemas: ¿Cómo se percibe el dominio del tema? ¿Y la claridad? ¿Qué consideraron para la calificación general? ¿Entendemos todos lo mismo por dominio del tema y claridad?

Rubega y colaboradores argumentan que probablemente hay poco consenso entre el público sobre qué constituye una buena comunicación (y todos sus rasgos, es decir, claridad, dominio del tema, etc.) y que esto puede afectar a la evaluación (Rubega et al., 2020). Sin embargo, este problema puede ser resuelto al ponderarse con otras evaluaciones, como la autoevaluación de los participantes y las observaciones de la capacitadora, que es lo que se hizo en esta tesis (Rodgers et al., 2018). No obstante, es importante tener en cuenta esta limitación en la evaluación.

En este mismo sentido, debido al tiempo y recursos limitados, no se pudo organizar que los participantes dieran una charla previa al taller para tomar esto como “línea base” de conocimientos y habilidades, y así poder evaluar qué tanto mejoraron con el taller. Para futuras ediciones convendría incorporar al programa que se presenten estas primeras charlas.

Por otro lado, los participantes sintieron la necesidad aplicar lo aprendido en clase con más prácticas. Se podría dejar una tarea extra entre las sesiones 2 y 3 que les permita practicar la presentación y estar mejor preparados para la sesión 4 (en donde se ensayaron las charlas). Un ejemplo de tarea que permitiría hacer esto, es la grabación de un video de 2 minutos en donde presenten su charla. Este ejercicio permite practicar sus habilidades de síntesis (facilitando la delimitación del tema) y pone a prueba su habilidad para usar lenguaje sencillo y claro.

Otro punto importante para considerar es el número de participantes que tomó el taller. Sólo 7 personas tomaron el taller completo y presentaron sus charlas finales por Facebook Live. Este es un número reducido y por lo tanto los resultados difícilmente se pueden considerar representativos del universo potencial de personas interesadas en adquirir estas herramientas de comunicación. Sin embargo, la intención de este taller piloto fue probar una metodología de diseño y evaluación, no obtener un análisis exhaustivo de los resultados.

El desarrollo de metodologías para la práctica de la CPC y, en este caso para capacitar en la práctica es quizás uno de los mayores desafíos de nuestro campo, lo cual no debería disuadirnos de emprender esta compleja tarea, que hoy más que nunca necesita evidencia sistemática y comparable. La recompensa de superar este reto podría ser sumamente reconfortante: lograr que ni científicos ni capacitadoras vayan a “ciegas” a la hora de enseñar y planear una charla de divulgación científica.

nueva página del texto (beta)

nueva página del texto (beta)